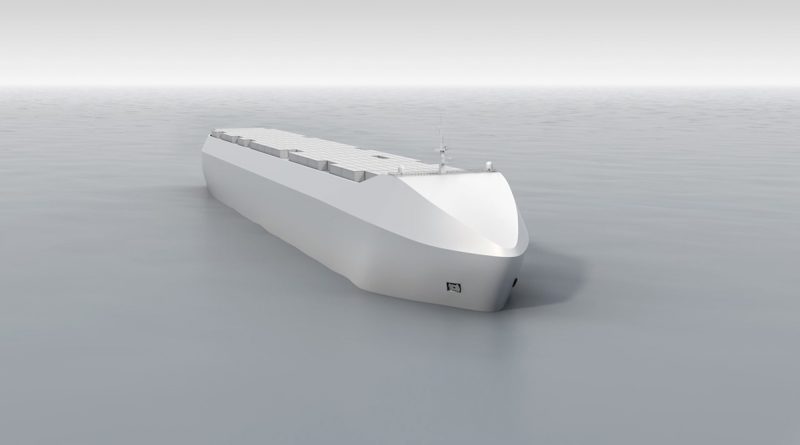

Autos y portacontenedores autónomos comparten preocupaciones y problemas

Los problemas que afectan a la industria de vehículos autónomos dentro del segmento automotor son paralelos al escenario que enfrenta el segmento de barcos autónomos según se habló en la conferencia Autonomous Ship Technology en Amsterdam.

Stig Peterson, científico senior de la organización de investigación independiente de Noruega SINTEF, habló sobre las lecciones que las naves autónomas podrían aprender del segmento automotriz autónomo, para mantenerse vigilante en los escenarios que podrían salir mal y definir mejor su hoja de ruta para el despliegue comercial indicó Freightwaves.

Peterson habló sobre cómo la seguridad es un principio fundamental del desarrollo del automóvil y cómo se puede lograr en el espacio mediante el uso de formas efectivas de barreras. “Una definición típica de seguridad es liberarse de un riesgo aceptable de daño a los humanos. Pero ahora, también significa estar libre de daños humanos, a la propiedad o al medio ambiente, las dos cosas más relevantes para los barcos», dijo.

Estas barreras pueden ser físicas o mediante sistemas de control definidos por computadora que pueden asumir el trabajo de un ser humano. Esto último es especialmente cierto para tareas repetitivas y redundantes como conducir, que una computadora podría mejorar sustancialmente porque no tiene fallas de concentración, una ocurrencia frecuente con humanos detrás del volante.

Uno de los mayores desafíos relacionados con los buques y automóviles autónomos es la prevención de colisiones y la detección de obstáculos. Peterson señaló que es un problema que amenaza el futuro de la tecnología semiautónoma, porque cuanto mejor sea la tecnología, mayor será la posibilidad de que los humanos no actúen de manera responsable durante las pocas veces que se ven obligados a tomar el control del vehículo.

Por ejemplo, si la tecnología de conducción autónoma de un vehículo encuentra con frecuencia escenarios que requieren que los humanos retomen el control, el humano en el asiento del conductor estaría mucho más atento.

Sin embargo, si la tecnología de conducción autónoma está altamente evolucionada, abordando la mayoría de las complejidades de la conducción por sí misma, el humano en el asiento del conductor puede volverse letárgico y desatendido al volante, ya que rara vez necesita tomar el control.

Aunque esta parece ser una posición favorable para estar, un escrutinio más detallado y casos prácticos han demostrado que lo contrario es cierto.

Cuantas menos intervenciones se requieran, más lento será el nivel de respuesta de emergencia del ser humano detrás del volante, lo que provocará accidentes debido a los lentos tiempos de reacción del ser humano.

El incidente de Uber en 2018 que mató a un peatón en Arizona, tuvo la culpa del humano, al menos parcialmente. El accidente ocurrió porque el conductor no tomó medidas evasivas en la fracción de segundo cuando el vehículo autónomo devolvió el control al humano, en un intento de evadir al peatón que cruzaba la carretera.

Después del accidente, se reveló que el sistema de frenado de emergencia en el automóvil sin conductor se apagó, ya que se comportó de manera errática durante el tiempo en que se encendió. El sistema de frenado de emergencia era extremadamente sensible incluso a los más mínimos obstáculos, frenando incluso cuando había una hoja soplando frente a él o un trozo de papel volando al viento, esencialmente, lo que lo hacía poco confiable.

Sin embargo, con el sistema de frenado de emergencia apagado, el humano en control perdió su tiempo de reacción, lo que condujo al desafortunado incidente.

“Como humanos, ustedes se sientan en el automóvil, ocho horas al día durante un año, y nunca pasa nada con los automóviles que conducen solos. Pero, ¿se puede confiar o depender de las personas para que actúen en un segundo aviso cuando algo sucede repentinamente fuera de lo habitual?», preguntó Peterson.

En última instancia, para que la autonomía funcione en las carreteras, es esencial definir no solo los niveles de automatización, sino también crear un marco concreto de quién sería responsable en caso de accidente causado por un vehículo autónomo.

“Un sistema debe considerarse autónomo si puede aceptar legalmente la responsabilidad u obligación por una operación. La tecnología actual no es lo suficientemente buena para evitar colisiones o detectar obstáculos, porque un operador humano ahora tiene el control del sistema”, dijo Peterson.

Y fue cauteloso en su declaración, destacando sus preocupaciones sobre las deficiencias de la tecnología, y finalmente concluyó diciendo que todas las partes interesadas clave como los programadores de software, los fabricantes de equipos originales, los usuarios y los organismos reguladores deben unirse para crear un ecosistema que es a la vez infalible y responsable cuando hay un error.

Fuente : MasContainer